本期展示

#名人名言# 【暂无】

责任编辑:小菜

#科技前沿#比sam快50倍的通用视觉模型fastsam(Fast Segment Anything)

MetaAI提出的能够“分割一切”的视觉基础大模型SAM提供了很好的分割效果,为探索视觉大模型提供了一个新的方向。虽然sam的效果很好,但由于sam的backbone使用了vit,导致推理时显存的占用较多,推理速度偏慢,对硬件的要求较高,在项目应用上有很大的限制。

最近看到FastSAM,论文结果最快提出50倍,参数更少,显存占用减少,适合应用部署。

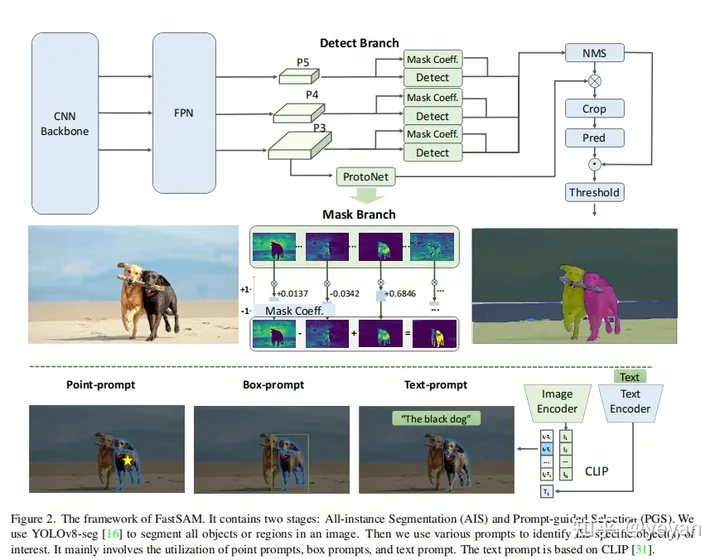

如上图,fastsam主要分成2步:全实例分割(all instance Segmentation)和基于prompt的mask输出(Prompt-guided Selection)。

全实例分割(all instance Segmentation)

1)模型:基于yolov8的模型,具体可以查看ultralytics. (2) 实例分割:yolov8-seg实现了实例分割,结果包含了检测和分割分支。检测分支输出box和类别cls,检测分支输出k(默认为32)个mask分数,检测和分割分支是并行的。这块就是yolov8的segment网络,具体可以看yolov8。

基于prompt的mask输出(Prompt-guided Selection)

利用prompt挑选出感兴趣的特点目标,类似sam,支持point/box/text。

效果展示

小结

这篇文章介绍了一种新的通用视觉模型fastsam,它可以比sam模型快50倍地分割任何物体,包括点、框和文本。文章主要介绍了fastsam的两个步骤:全实例分割和基于prompt的mask输出。文章还给出了一些实验结果和代码示例。

转载自知乎yeyan 责任编辑:小菜